Cum putem instala un LLM local pe calculatorul personal

Folosirea tool-urilor bazate pe AI a devenit in ultimii 2 ani un lucru din ce in ce mai comun dat fiind faptul ca foarte multe companii sau oameni au inceput sa faca aceasta tranzitie, spre acest tip de instrumente de lucru.

Optiunile „clasice” precum aplicatiile de Large Language Model care genereaza raspunsuri de tip text preponderent precum Chat GPT, Gemini sau DeepSeek sunt deja extrem de cunoscute printre majoritatea utilizatorilor, atat din IT cat si celor mai putini tehnici.

Insa o alternativa interesanta la aceste aplicatii care ruleaza si stocheaza implicit datele pe servere din strainatate (SUA sau China in cazul DeepSeek), este instalarea si rularea unui LLM chiar local, pe calculatorul nostru personal.

Link-uri cu care vom lucra in acest articol:

Ce intelegem mai precis printr-un „LLM local”?

Chat GPT sau Gemini sunt aplicatii de tip LLM, deci o inteligenta artificiala specializata care livreaza raspunsuri in format text si care pot fi accesate prin interfata lor proprie, din browser sau pe mobile, ruland pe serverele lor proprii si rezervandu-si dreptul de a stoca toate datele pe care noi, utilizatorii, le dam prin chat field, ajutand astfel in mod direct la „hranirea” statistica a acestor modele.

O aplicatie de LLM instalata local se deosebeste prin faptul ca noi, cu ajutorul anumitor aplicatii-client, putem sa ne configuram statia de lucru personala (PC sau laptop) sa devina gazda pentru un model LLM, de regula unul open-source sau care are posibilitatea de configurare locala. Practic, ne setam computer-ul personal sa devina propriul server pentru o aplicatie de tipul lui Chat GPT, dar care sa „traiasca” doar la noi pe PC, sa nu trimita datele in alte parti.

In acest mod, ne putem configura un LLM local, cu anumite setari in functie de ce optiuni alegem sa instalam si de care vom discuta imediat, sa ne ajute astfel in mod particular la proiectele noastre personale.

Cum putem instala un LLM local?

De la inceput trebuie mentionat ca exista mai multe modalitati de a instala si configura astfel de modele de LLM local. Voi prezenta doua alternative, ambele destul de simple pentru a fi incercate de oricine. Singura conditie universala pentru ambele ar fi partea hardware: ca sa nu avem probleme de configurare sau stocare, ar fi ideal sa avem un folder creat special pe o partitie unde stim ca avem mai mult spatiu de stocare la dispozitie, sa avem cativa GB buni de care sa ne putem folosi, o memorie RAM de macar 16 GB, si de asemenea de un procesor si o placa grafica decente.

Daca computer-ul e unul mai vechi, exista riscul sa nu putem instala LLM-ul local sau sa functioneze cu sincope. Sa vedem exemplele propuse.

1. GPT4All

Un prim exemplu prin care ne putem instala fara mari probleme sau cunostinte tehnice un LLM local, fiind printre cele mai simple posibile astfel de solutii, este GPT4All. Aceasta este o aplicatie open-source, existand la liber pe GitHub, pe care o putem instala local si prin intermediul careia putem sa ne descarcam ulterior un model LLM local, open-source.

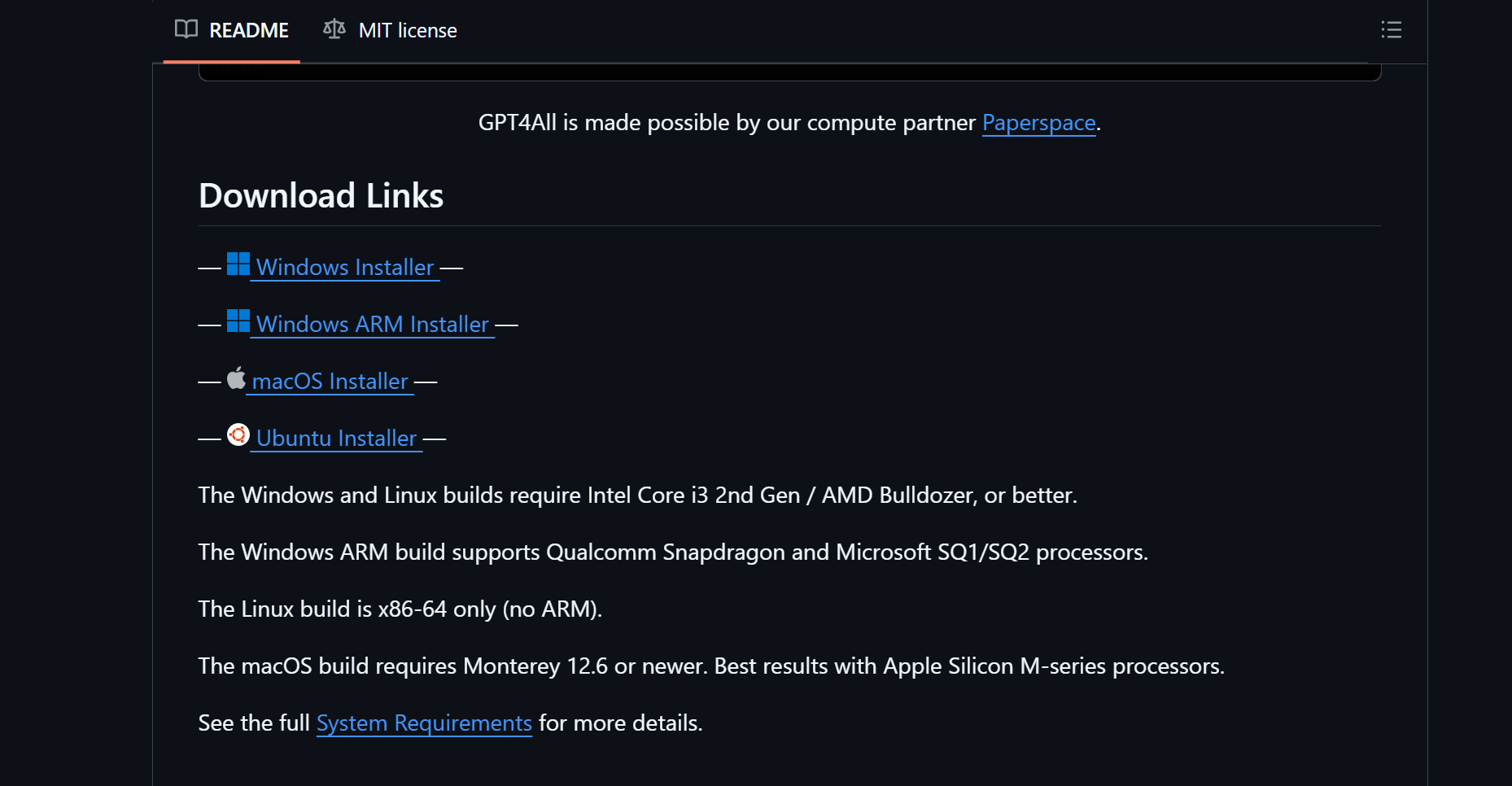

Pasii de instalare sunt extrem de simpli. Trebuie doar sa cautam pe internet “GPT4All install”, sa intram pe pagina de GitHub a proiectului si acolo vom gasi link-urile pentru installere adaptate in functie de sistemul nostru de operare (Windows / Linux / macOS).

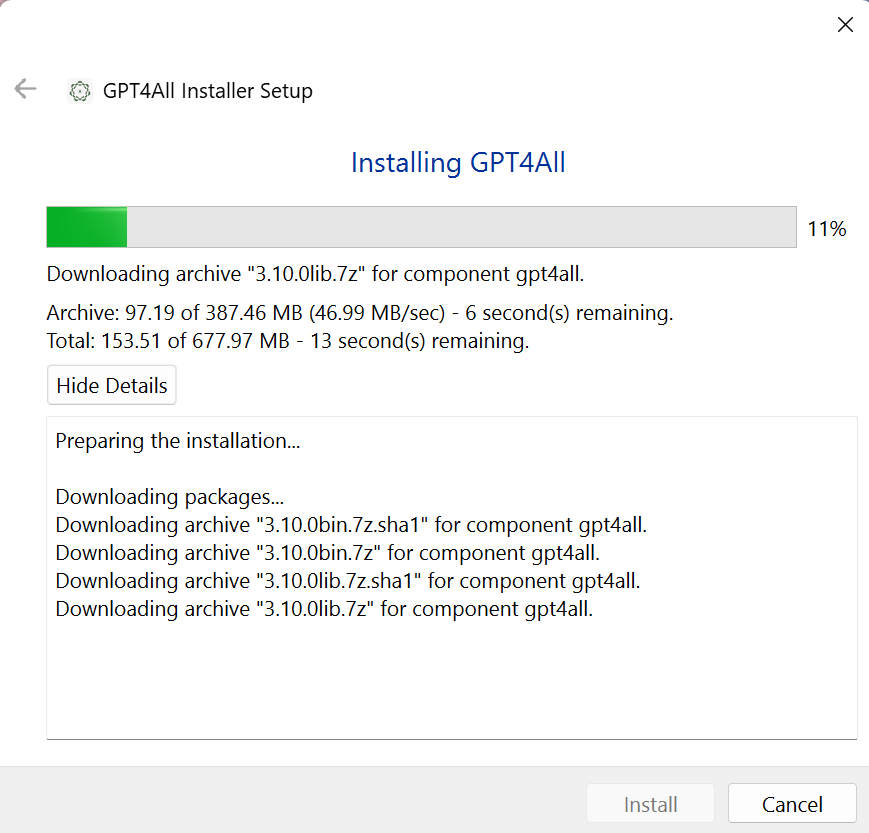

Descarcam installer-ul de care avem nevoie, si il instalam ca orice alta aplicatie normal de desktop, dand click pe “Next”, pana la “Finish”. Aici o sa fim intrebati in ce locatie vrem sa instalam GPT4All cat si modele LLM pe care vom vrea sa le rulam prin intermediul acestuia. Recomand sa va faceti un folder pe o partitie unde stiti ca aveti macar 10-15 GB liberi, pentru a rula in parametri optimi.

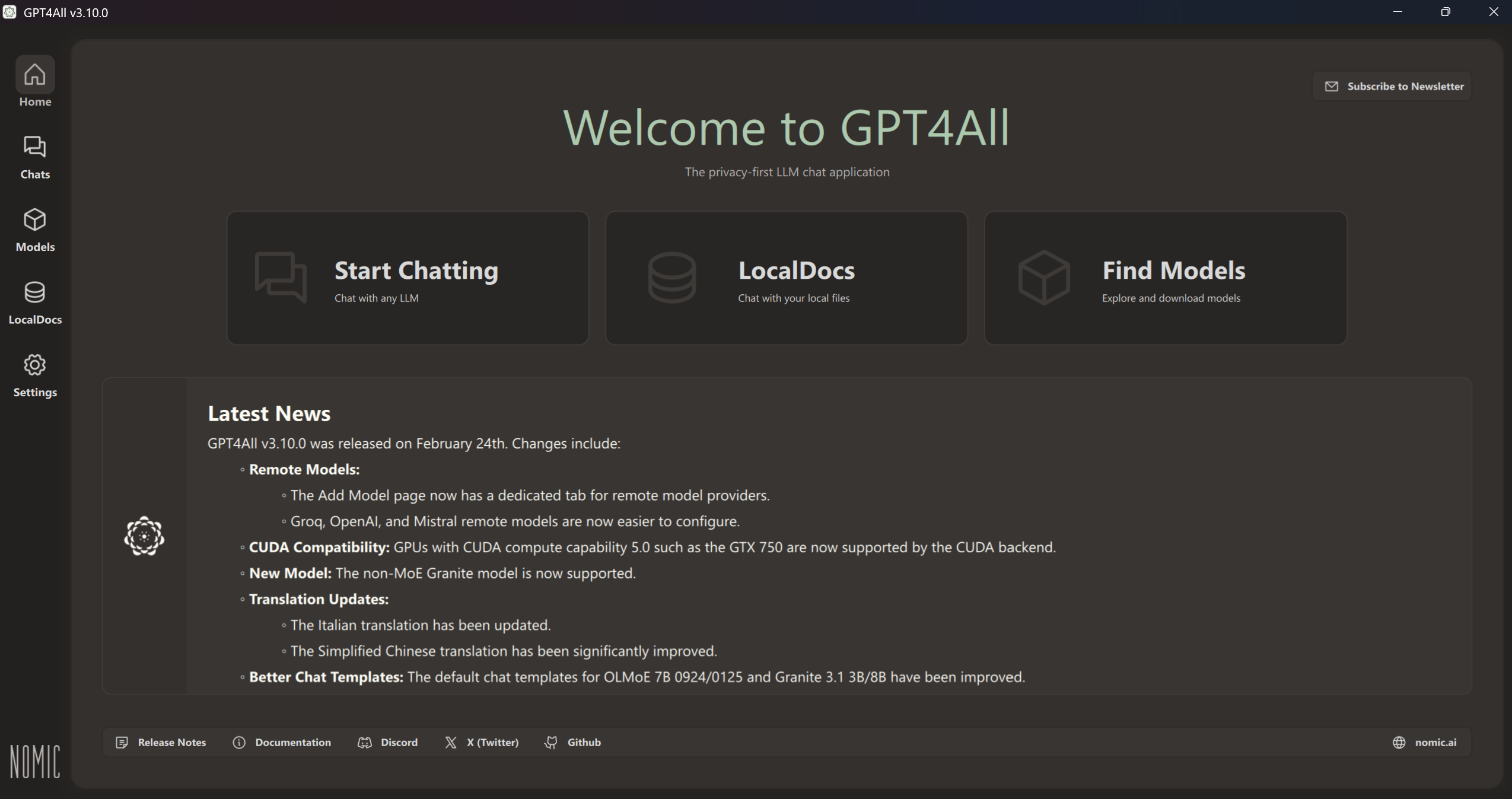

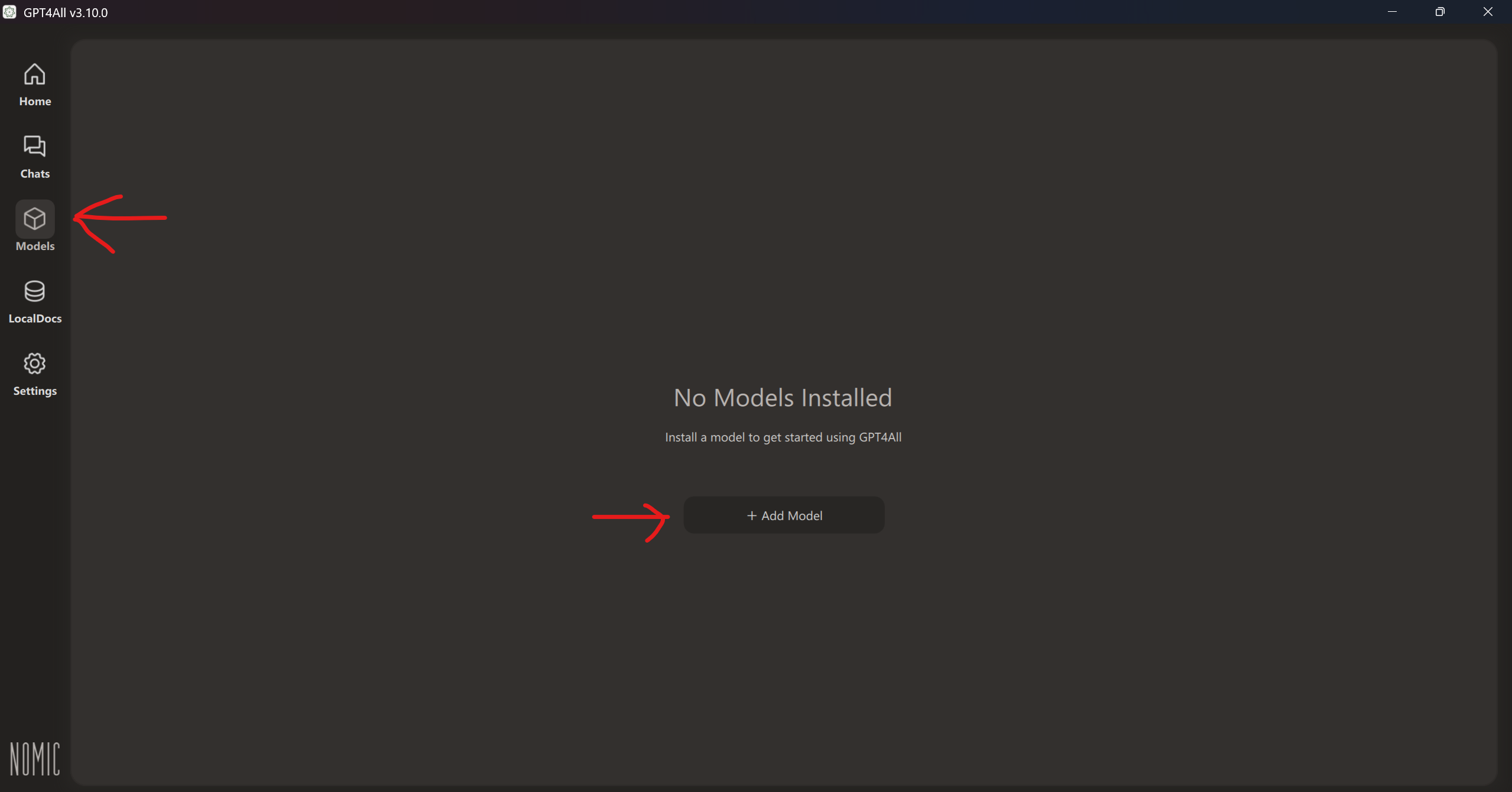

Dupa ce s-a instalat, putem accesa GPT4All ca o aplicatie obisnuita. Putem sa il configuram in sine cu setarile pe care ni le dorim, si ulterior sa instalam un LLM. De la tab-ul de Models din partea stanga, dam click iar aici avem o lista cu modele LLM deja propuse pe care le putem descarca spre folosire cu doar un singur click de mouse.

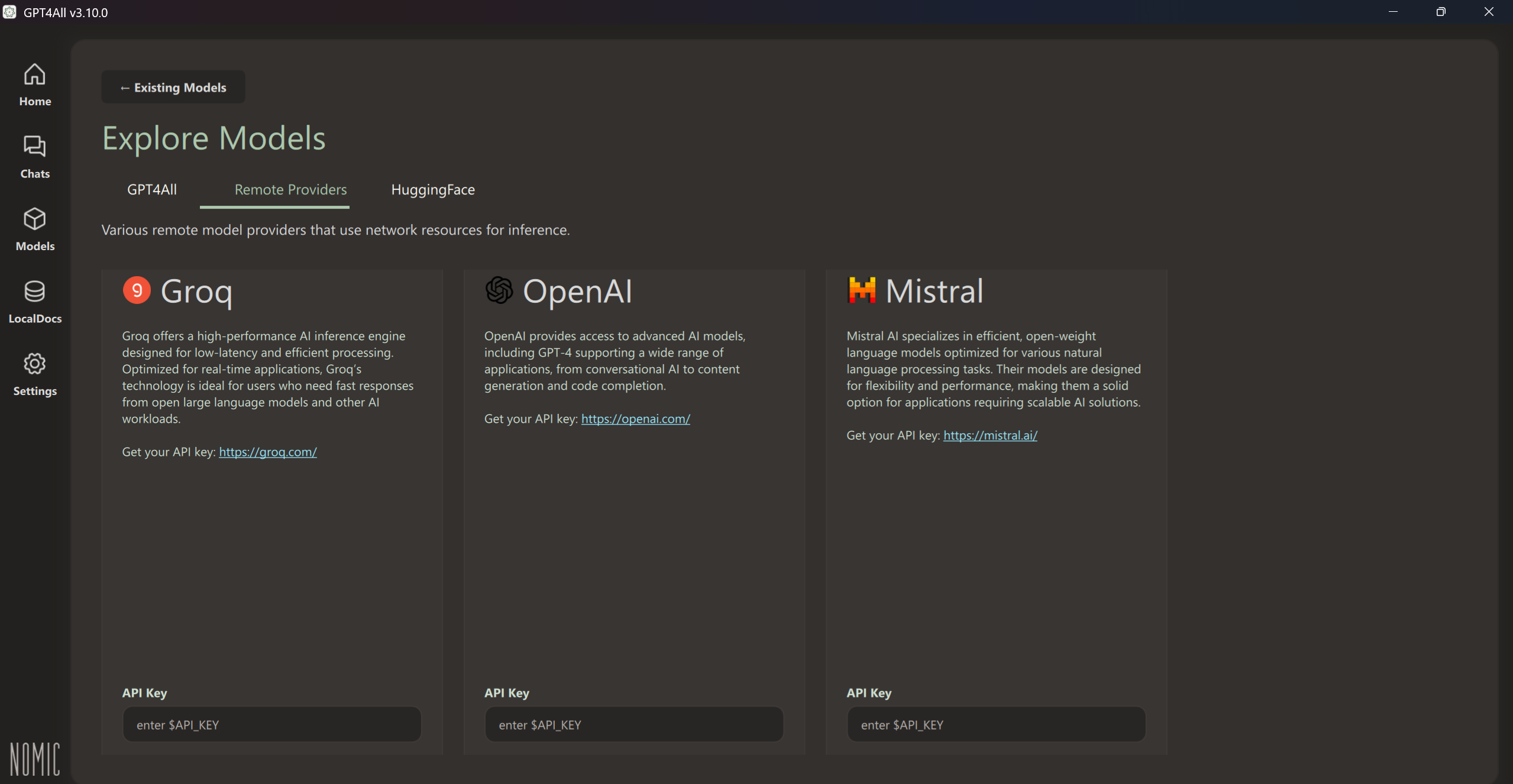

Exista cativa provideri principali care au adaugat pana acuma modele LLM open-source si pe care le putem instala la liber, fara costuri, unul dintre ei fiind compania chineza DeepSeek care a lansat un concurent la ChatGPT dar cu mai putine resurse si (zic ei) mai performant.

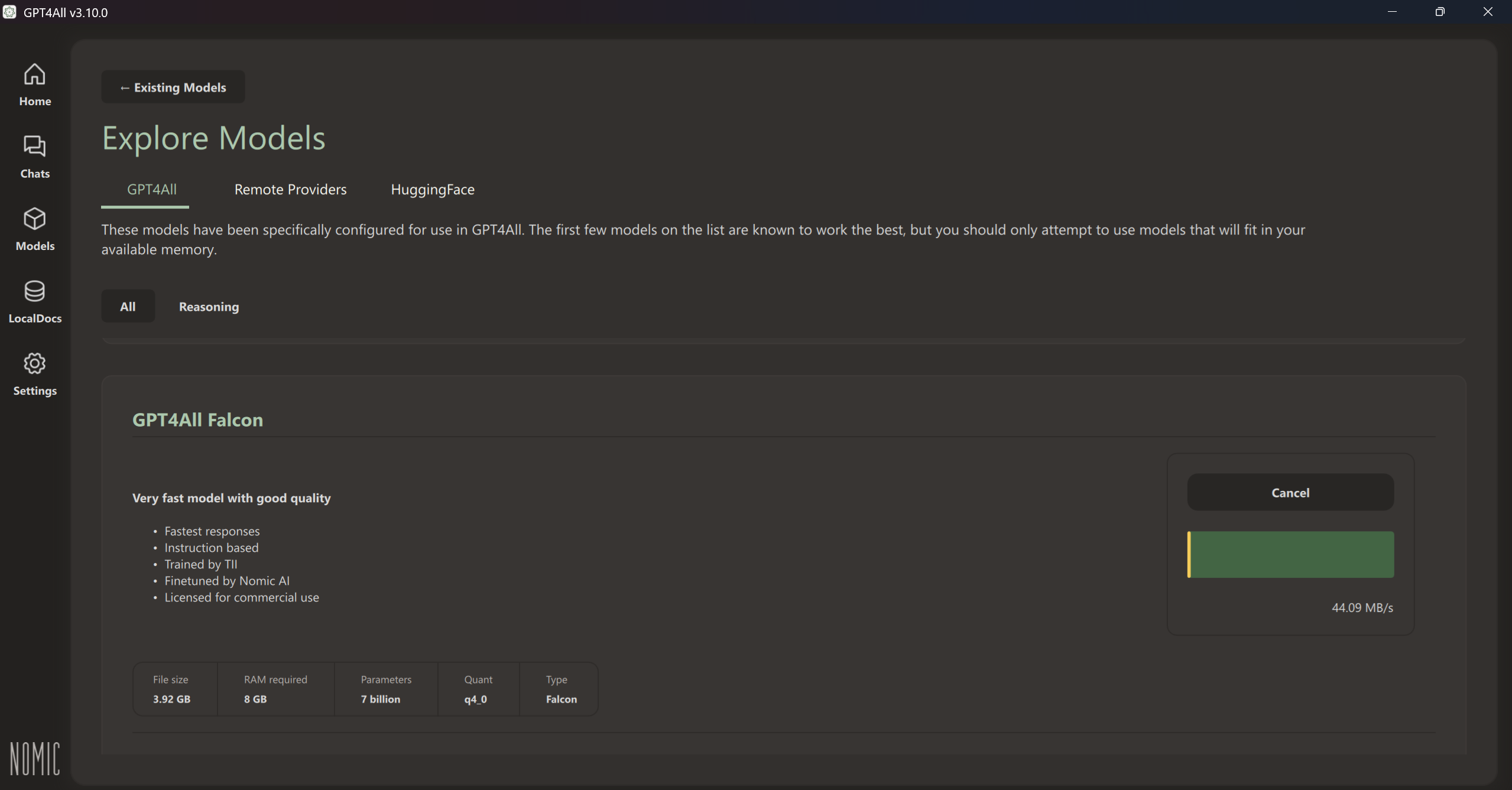

Aici sunt multe optiuni de modele, unele mai mici ca dimensiuni dar care au si un numar redus de parametri, deci putin mai slabe d.p.d.v. al performantei, dar si altele cu mai multi parametri, mai bune dar si care consuma mai multa memorie.

Eu am ales modelul GPT4All Falcon. Ii dam Install, si dupa avem o interfata de chat extrem de asemanatoare cu a lui Chat GPT prin care il putem interoga, sa ne livreze diverse raspunsuri.

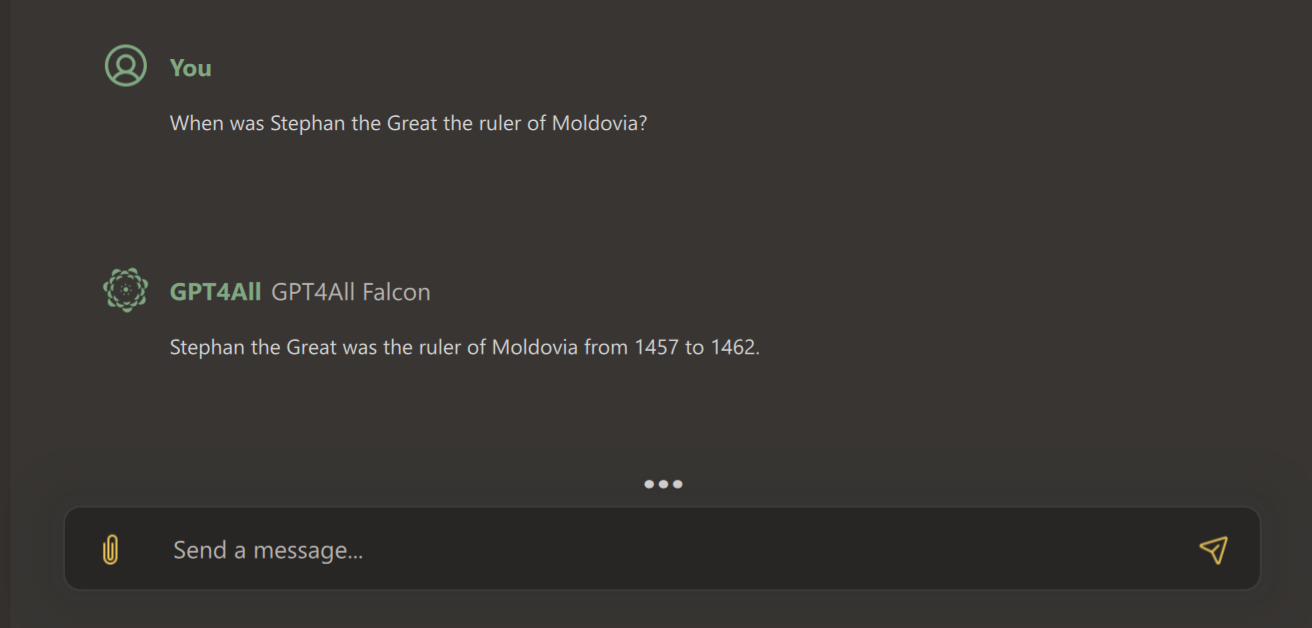

Aici insa trebuie facuta o precizare extrem de importanta. Aceste modele open-source rulate ca atare sunt extrem de imprecise pentru ca ele nu au context, fiind doar un nucleu de baza care nu ruleaza de pe un server extern de unde sa acceseze alte informatii. Practic, ele nu stiu prea multe, luate ca atare.

Drept exemplu, l-am intrebat pe GPT4All Falcon cand a domnit Stefan cel Mare in Moldova si mi-a raspuns ca intre 1457 (anul de debut e corect) si 1462 (complet gresit, Stefan cel Mare avand una dintre cele mai lungi domnii din spatiul romanesc medieval, pana in 1504).

Aici rezida esenta acestor modele LLM instalate local, sa le configuram noi cu date de context dupa nevoile noastre. Spre exemplu, daca as vrea ca LLM-ul meu sa ma ajute cu lucruri de istorie, ar trebui ii ofer surse de suport si date externe.

Pentru asta, mergem la LocalDocs in partea stanga, si ne cream o colectie de date. Practic, alegem de pe computer-ul nostru unul sau mai multe foldere pe care le incarcam si compilam in LLM-ul local, astfel incat Falcon in cazul nostru sa se poate folosi de ele si sa ne ofere data viitoare raspunsuri mult mai precise si corecte.

2. Ollama

A doua varianta, putin mai tehnica, este folosirea aplicatiei intermediare Ollama. Aceasta functioneaza ca si GPT4All ca o legatura intre noi si instalarea LLM-urilor locale, care sa ne ajute ulterior sa le folosim in diferite proiecte.

Pasii pe scurt sunt:

- Instalam Ollama de pe pagina lor oficiala ca orice aplicatie de desktop (Install -> Next -> Finish).

- Instalam un model LLM din terminalul de comanda, folosind comanda ollama pull <numele_modelului_LLM>. Pentru ca gasi o lista cu modele din care sa putem alege, intram tot pe site-ul aplicatiei Ollama.

- Instalam fie o extensie de browser care sa ne asigure acea interfata de chat, mergand in Chrome Web Store si cautand “ollama chat”, fie instalam aplicatia Open Web UI.

Pentru a folosi varianta mai stabila cu Open Web UI, aici trebuie sa indeplinim cateva preconditii, si anume: sa avem instalat limbajul Python deoarece gestiunea pachetelor de aplicatie se va face prin intermediul acestuia, sa ne asiguram ca avem un computer cu cerinte hardware bune (memorie de stocare mai mare pe o partitie, RAM de cel putin 16 GB, CPU si o placa grafica performante), ideal si sistemul de versionare Git instalat.

Pentru a nu folosi locatia implicita de pe partitia C (pe Windows) pentru Ollama si pentru a nu ramane fara memorie pe aceasta, sugestia este sa ne cream o variabila de sistem numita OLLAMA_MODELS si sa ii dam valoarea path-ului acelui director in care vrem sa instalam aplicatia si modelele LLM ulterioare, pe o partitie mai libera.

Comparativ cu primul exemplu, cel oferit de GPT4All, varianta cu Ollama si eventual Open Web UI necesita ceva mai multe resurse pe computer-ul personal, dar poate fi o aditie super utila si stabila in functie de ce ne dorim, si cat de performant vrem sa fie modelul LLM local.

Avantajele unui model LLM local

Dupa cum incepusem sa mentionez si in paragrafele anterioare, exista mai multe avantaje pe care le poate aduce un LLM instalat local, sub forma de open-source, pe calculatorul nostru personal.

Primul si probabil cel mai important este dat de o siguranta mai mare a datelor cu care lucram din proiectele noastre personale sau profesionale. Aceste date le incarcam pentru LLM-ul nostru si acesta le va folosi doar in „curtea noastra privata” fara sa le trimita pe vreun server in afara tarii si de acolo sa fie folosite pentru a antrena alte aplicatii AI.

Al doilea avantaj este acela ca aceste modele pot rula independent, si fara conexiune la internet si astfel putem sa ne continuam treaba cu ele si daca se intampla ceva in acest sens. Daca de exemplu folosim Chat GPT si serverele pe care ruleaza pica, atunci nici utilizatorii de rand nu il mai pot folosi. Insa acestea au deja in spate o baza de date pe care o folosesc ca sa ne ofere raspunsuri la intrebari.

Un alt avantaj este desigur cel al costurilor. Folosirea modelelor super performante de Chat GPT sau Gemini se bazeaza pe achizitia de subscriptii platite, si care nu sunt chiar ieftine. Un model LLM local se poate instala dupa cum am vazut destul de rapid, si configura de asemenea maniera incat sa ne foloseasca la proiectele la care lucram.

Singurul aspect care trebuie avut in vedere aici, la partea de costuri, este ca trebuie sa folosim anumite echipamente hardware mai performante din perspectiva memoriei de stocare, a celei RAM, a procesorului si a placii grafice. O astfel de investitie poate necesita resurse mai serioase.

Concluzii

In incheiere, instalarea si configurarea unui LLM local constituie o alternativa interesanta si utila din mai multe puncte de vedere la aplicatiile company-based consacrate deja, precum Chat GPT.

Procesul de instalare este unul destul de simplu, internetul fiind plin de astfel de exemplu, eu prezentand aici doar 2 dintre cele mai cunsocute astfel de solutii. Dar suntem liberi sa cautam si sa incercam tot ce dorim, alternativele fiind multe si interesante.

Daca stim ca lucram la anumite proiecte cu date mai sensibile si nu vrem ca acestea sa „fuga” in alta parte, atunci folosirea LLM-urilor open-source se poate dovedi, de la caz la caz, o idee de luat in seama.

Surse

Un articol cu 7 modalitati super simple de a instala un LLM local

Rularea unui LLM local cu Ollama prezentat pe toate sistemele de operare (Windows/Linux/macOS) + versiunea mai detaliata cu Open WebUI

Site-urile de unde poti descarca GPT4All si Ollama + Open Web UI

Un video foarte bun de la Zona IT / Playground despre LLM-uri locale (DeepSeek)