Riscuri de securitate in folosirea AI

In cea mai mare parte, multi dintre noi am experimentat deja folosirea unei aplicatii LLM sau AI assistant precum Chat GPT, Gemini, Claude sau Perplexity, in diferite sarcini de lucru, mai personale sau mai legate de job-ul nostru.

Acest lucru a devenit o recurenta precum cautatul pe Google atunci cand nu stim raspunsul la o intrebare sau nu stim cum se rezolva un anumit lucru, tot in sens profesional ori personal. Insa ca in aproape orice chestie legata de folosirea anumitor aplicatii software, cu timpul se dezvolta si riscurile si amenintarile de securitate, din sfera cybersecurity. Asa ca mai departe vom discuta despre ce riscuri de securitate presupune azi folosirea Inteligentei Artificiale in sfera profesionala.

Contextul problemei

De la inceput trebuie facuta o mentiune de bun-simt, ca sa nu se creada ca „doar” AI-ul e vinovatul principal. Toate aplicatiile software care exista si sunt folosite pe acest pamant prezinta riscuri de securitate, mai mari sau mai mici, in functie de cat de bine este optimizata si cat de mult i se acorda suport pe partea de remediere a problemelor.

Aplicatiile AI / LLM folosite acum de marea parte a oamenilor sunt cu siguranta mai recente decat altele si implicit acum se descopera si se afla public de aceste riscuri la care probabil nu ne-am gandit deloc pana acuma.

Chat GPT a fost lansat oficial in noiembrie 2022, iar recent a ajuns la versiunea GPT-5 care a fost lansata publicului la inceputul lui august 2025, ceea ce ne arata ca desi OpenAI se straduieste sa scoata constant (si chiar destul de repede) versiuni noi, mai bune si mai eficiente, aceasta „ardere” a etapelor nu poate compensa timpul foarte scurt de cand a fost lansata aplicatia, si implicit nici remedierea riscurilor de securitate nu se poate face peste noapte.

Folosirea AI-ului in scopuri profesionale

Dincolo de popularitatea initiala a acestor aplicatii cu AI, cand era la moda sa generezi imagini care mai de care mai „originale” cu Midjourney sau sa faci un eseu la literatura cu Chat GPT, aceste LLM-uri au devenit treptat treptat o unealta tot mai integrata si folosita in scopuri profesionale.

In general aceste aplicatii de tip chat bot sau care creeaza anumite lucruri (rezumate, imagini, editari video-foto etc.) au inceput sa devina un sprijin nelipsit pentru o buna parte din angajatii din economie, cu precadere in cazul job-urile white collar (adica cele preponderent „de birou”, care implica rationamente, analize, creativitate sau logica).

Procentul celor care folosesc AI frecvent sau ocazional la job in Romania a evoluat ascendent in ultimul an si jumatate, de la circa 40% la inceputul lui 2024 pana pe la 75% la inceputul lui 2025. Desigur, sondajele si metodologiile sunt diferite, niciun sondaj nu trebuie luat ca litera de lege, si apar diferente semnificative de la un domeniu la altul (ex.: una e in IT, alta e in cercetare), dar ideea generala e ca AI-ul a devenit un instrument intalnit si folosit constant la job, precum internetul, pentru a aborda si rezolva diferite sarcini de lucru, pe partea de programare sau testare software.

Din punct de vedere la tipurilor de licente folosite pentru aplicatiile AI la job, aici de regula se disting 2 categorii principale. Prima categorie e data de cei care folosesc versiunile gratuite / free, la liber de pe internet cu ajutorul unui cont personal (cu o adresa de email personala si nu de la munca). Aceasta formula e mai accesibila pentru ca e mai rapida si ieftina, nu trebuie sa platesti nimic, insa apar limitari de prompt-uri / zi, poate nu cele mai rapide si de calitate rezultate, iar pe desaupra lipseste garantia ca input-urile pe care le dai nu ajung ulterior la alte persoane de pe internet.

A doua categorie e reprezentata de folosirea AI-urilor platite, cu licenta de catre compania / startup-ul angajator pentru angajatii sai (toti sau doar o parte). In aceasta formula, de regula angajatii isi creeaza un cont cu adresa de email / credentiale de la munca, accesul e securizat si restrans doar la adresa de email respectiva plus eventual alte metode (de exemplu poate exista protectie de tip 2FA), iar acel chat bot este accesat ca intr-un fel de sandbox.

Acest lucru ofera o garantie suplimentara (prin contract) ca acel AI are acces la codul de baza al echipelor (in IT) si la documentatiile de proiect, astfel incat sa le acceseze mai rapid si sa ofere raspunsuri mai bune pe baza prompt-urilor. De asemenea, este si o formula mai sigura ca output-urile si informatiile de baza nu vor scapa pe internet, cel putin in teorie.

Riscuri de securitate privind folosirea AI-ului

Pornind de la categorizarea anterioara a folosirii AI-ului la job, ajungem la miezul problemei, si anume la riscurile de securitate pe care le implica folosirea AI-ului la job, axat pe cazul domeniului IT (testare, programare etc.).

Astfel, ca sa incepem cu ele intr-o ordine mai mult sau mai putin aranjata, riscurile de securitate in folosirea AI-ului pot fi:

- Riscul ca informatii confidentiale sa scape la liber pe internet

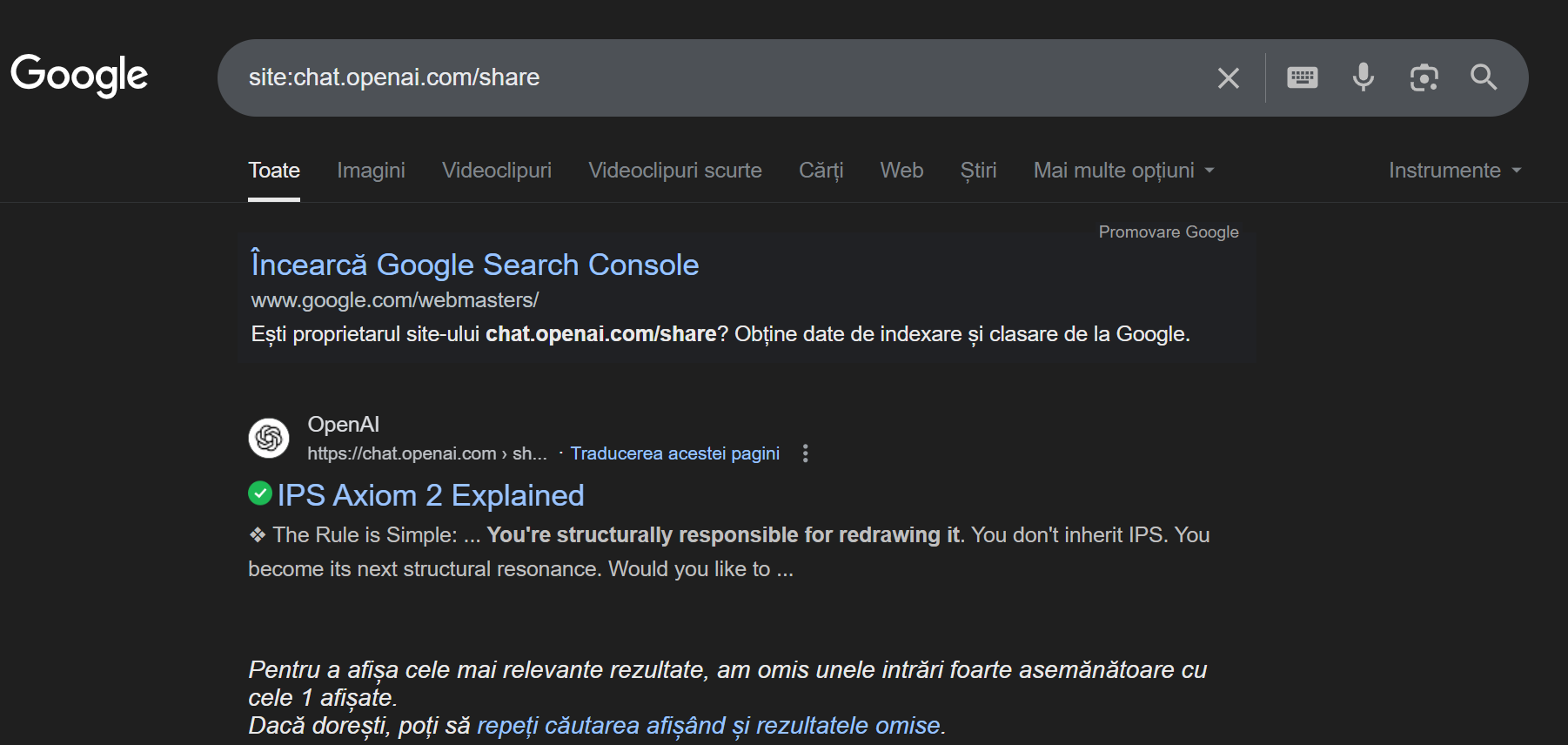

Acesta e probabil principalul risc de care trebuie sa tinem seama atunci cand folosim un tool AI / LLM la job. Daca in cadrul sau apare o bresa de securitate si nu se mai respecta acel sandbox in cadrul caruia il folosim, atunci codul sursa al aplicatiilor, documentatiile interne sau date de produs sensibile ar putea circula apoi la liber si sa fie accesate din acelasi LLM sau de pe internet, de catre atacatori software. De exemplu, thread-urile de discutie pe Chat GPT pot fi setate sa fie publice, si ulterior daca cautam o anumita sintagma pe Google, e posibil sa dam peste conversatii ce nu ar trebui sa fie publice.

- Folosirea fara permisiune a tool-urilor AI

Asa cum mentionam si mai sus, multi nagajati opteaza sa foloseasca chat botii AI cu conturile personale, fiind poate mai comod, mai ales daca comapnia nu ofera acest mecanism. Insa trebuie sa fim extrem de atenti. E foarte posibil ca in lipsa unui acord (agreement) foarte clar comunicat, compania sa nu permita de fapt folosirea tool-urilor AI necontractate tocmai pentru a nu-si asuma riscul de la punctul 1, ca date interne sa scape pe internet. Mai mult, chiar daca sa zicem compania angajatoare permite folosirea de AI, in cazul celor de outsourcing conteaza extrem de mult si acordul clientului.

Daca nici acesta din urma nu e de acord sa primeasca produse si servicii la care a contribuit (direct sau indirect) AI-ul, atunci nici noi ca angajati nu le putem folosi. Altfel, riscam sa suferim consecinte. De aceea, verifica NDA-urile si politica interna a angajatorului inainte de a ii da o bucata de cod lui Chat GPT la refactorizat. Riscul de securitate aici e sa te compromita pe tine personal, si ulterior reputatia companiei angajatoare.

- Folosirea rezultatelor indoielnice

Cu totii stim ca nu intotdeauna AI-ul ofera cele mai precise si corect rationate raspunsuri. Uneori acestea sunt foarte bune, alteori sunt complet pe langa intrebare. Insa daca noi ii cerem sa ne genereze o metoda, si noi o luam cu copy-paste pe „nemestecate”, adica fara sa o mai trecem deloc prin filtrul propriei noastre gandiri si experiente, atunci riscam sa facem push in codul de pe master a unui cod generat de AI plin de bug-uri, si care sa dea nastere la probleme de securitate ulterioare.

Acesta va ajunge la clienti, clientii se vor confrunta cu bug-urile respective, e posibil ca acel cod sa nu fie securizat 100% si sa conduca inclusiv la crash-uri in Productie. Desigur, e scenariul cel mai grav, dar nu e de neluat in seama. De multe ori, AI-ul se poate strica, poate halucina ca urmare a unor Adversarial attacks din partea hackerilor, ca sa il faca sa halucineze la anumite prompt-uri foarte folosite de oamenii de rand, si care sa conduca la vulnerabilitati introduse subtil in output-urile sale. Iar daca acele rezultate ajung sa fie folosite serios de angajatii altor companii, avem deja un risc major de securitate.

- Lipsa consistentei pentru un AI

Inclusiv in testare software se foloseste extrem de mult AI-ul. Si nu e deloc un lucru rau in sine, cu conditia sa o facem intr-un mod atent si sa ne folosim gandirea critica. Un mod destul de des folosit in care este folosit AI-ul aici poate fi acela de scrie mai rapid cazuri de testare (test cases) bazat pe documentatia produsului si a specificatiilor sale tehnice si de client, cunoscute mai des ca Acceptance Criteria. Acest mod clar e mult mai rapid, insa din nou trebuie sa fim atenti la acele test cases.

Ele pot fi mai complete sau mai lacunare, si trebuie citite atent inainte de a fi adaugate in suita de teste, pentru a nu scapa intentionat flow-uri netestate in Productie. Niciun AI nu va reusi perfect sa se plieze pe cerintele unui client, iar un ochi uman va fi necesar in continuare, altfel se va transforma tot intr-un risc de securitate ce va produce issue-uri. Aceleasi lucruri sunt valabile si pntru testele automate, ele trebuie sa fie valide si complete, si sa nu distruga date de productie.

- Pierderea controlului asupra datelor

Un alt risc de securitate legat foarte mult de cel de la punctul 1 este acela al pierderii controlului asupra datelor ce pot ajunge sa fie stocate si folosite de compania din spatele acelui tool AI in scopuri comerciale sau chiar punitive.

Aici ma refer atat la date private ale companiei, care tin de produse, de ce urmeaza sa lanseze, de statistici si analize de piata, dar si la date mai personale, ale angajatilor precum adrese de email, parole, date de testare si secrete. Acele date, daca exista brese de securitate in mecanismele acelui AI sau exista algoritmi secreti de procesare a lor implementati in secret de compania sa dezvoltatoare, pot fi stocate fara acordul lor pe anumite servere si exploatate in scopuri negative, chiar ofensive. Un caz asupra caruia planeaza suspiciuni rezonabile este cel al chat bot-ului DeepSeek ce a fost dezvoltat de mai multi cercetatori sustinuti consistent de guvernul Chinei. Modelul e unul open-source, foarte performant pe multe arii, dar nu recomand folosirea lui in scopuri profesionale, cu date sensibile.

Sfaturi si bune practici

Ca oricare alte potentiale riscuri, nu avem cum sa prevenim mereu 100% existenta si producerea lor, mai ales in domeniul cybersecurity. Daca prin absurd chiar ne-am dori sa nu ne riscam cu absolut nicio vulnerabilitate de securitate in privinta AI-ului, atunci singura solutie este sa nu il folosim deloc.

Pentru a veni totusi cu cateva idei de bun simt care sa ne fereasca in cele mai multe cazuri de asumarea unor riscuri inutile atunci cand folosim Chat GPT, Claude sau alte asemenea modele, esenta ar fi ca:

- Sa NU folosim modele AI / LLM cu conturi personale ce nu sunt contractate si permise in mod direct, explicit de catre angajator si clientii sai.

- Sa NU folosim cu scop personal, in joaca datele confidentiale ale firmei pe modele gratuite de unde informatiile respective pot scapa la liber. Ideal e sa avem acea licenta platita cu sandbox oferit si incorporat de companie.

- Trebuie sa fim atenti mereu la ce ne genereaza AI-ul. Poate fi un continut de calitate foarte bun, sau poate fi un cod plin de bug-uri care poate fi ulterior exploatat de red hackers. Gandirea critica si rabdarea in a lua cu un gram de sare rezultatele sunt cheia aici.

- Daca timpul permite, comparati rezultatele oferite cu un alt model AI sau din alte surse, pentru o acuratete si mai mare si rezultate finale mai de incredere.

- Daca vi se pune la dispozitie un AI de care nu ati mai auzit sau aveti anumite dubii legate de dezvoltarea lui, documentati-va asupra originii sale si a celui / celor care se afla in spatele sau.

Concluzii

In incheiere, folosirea instrumentelor din categoria AI / LLM a devenit o recurenta mai ales pentru job-urile de tipul white collar care presupun creativitate si rationament avansat pentru procesarea de date, astfel incat sa reducem timpii de lucru pentru sarcini repetitive sau care implica munti de date.

In mod cert, folosirea AI-ului in scopuri profesionale si nu doar pentru a cauta retete de clatite vine la pachet cu multe riscuri de securitate, unele generale, altele care tin de fiecare domeniu in parte. Unele pot fi prevenite in mare masura, altele mai putin, insa ce e important la final de retinut este sa urmarim constant evolutia acestor aplicatii si sa ne documentam despre potentialele riscuri si capcane care pot aparea de la o zi la alta, pentru a le recunoaste si a nu cadea in ele.

Surse pe subiect

Informatii generale despre riscurile de securitate ale AI-ului sunt aici, aici si aici.

Alte probleme si sfaturi de securitate in AI

Un articol foarte bun cu 10 riscuri legate de folosirea AI la munca

Sfaturi de preventie in materie de securitate AI de la Microsoft